机器学习之岭回归

问题引入

- 线性模型:$\mathop{min}_{w} {\Vert X w-y \Vert_2}^2$

- 岭回归: $\mathop{min}_{w} {\Vert X w - y \Vert _2}^2 + {\alpha \Vert w \Vert_2}^2$

- lasso:$\mathop{min}_{w} {\Vert X w - y \Vert _2}^2 + {\alpha \Vert w \Vert_1}$

在线性回归中,对于普通最小二乘的系数估计问题,其依赖于模型各项的相互独立性。当各项是相关的,且设计矩阵 X 的各列近似线性相关,那么,设计矩阵会趋向于奇异矩阵,这会导致最小二乘估计对于随机误差非常敏感,产生很大的方差。例如,在没有实验设计的情况下收集到的数据,这种多重共线性(multicollinearity) 的情况可能真的会出现。因此,是否可以删除掉一些相关性较强的变量呢?如果p个变量之间具有较强的相关性,那么又应当删除哪几个是比较好的呢?

岭回归

思想

岭回归通过对系数的大小施加惩罚来解决普通最小二乘法的一些问题。 岭系数最小化一个带罚项的残差平方和,

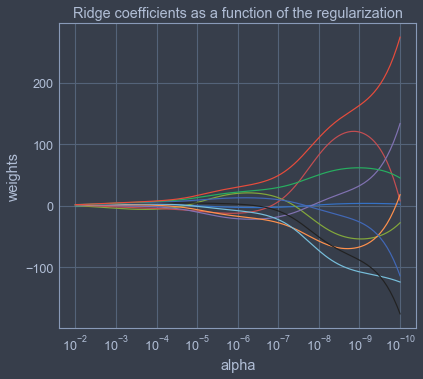

其中, $\alpha \geq 0$ 是控制收缩量复杂性的参数: $\alpha$的值越大,收缩量越大,因此系数对共线性变得更加鲁棒。

在不断增大惩罚函数系数$\alpha$的过程中,画下估计参数($\alpha$)的变化情况,即为岭迹。通过岭迹的形状来判断我们是否要剔除掉该参数(例如:岭迹波动很大,说明该变量参数有共线性)。

步骤

- 对数据做标准化,从而方便以后对($\alpha$)的岭迹的比较,否则不同变量的参数大小没有比较性。

- 构建惩罚函数,对不同的 $\alpha$ ,画出岭迹图。

- 根据岭迹图,选择剔除掉哪些变量。

公式

目标函数

对 $w$ 求导:

得到:

Plot Ridge coefficients as a function of the regularization

import numpy as np |

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Busyboxs!